Un improvviso calo del traffico organico può trasformarsi in un incubo per qualsiasi business online. Le penalizzazioni Google rappresentano una delle cause più temute di perdita di visibilità sui motori di ricerca, con conseguenze dirette su conversioni e fatturato.

Fortunatamente, riconoscere i segnali di una penalizzazione e intervenire con le giuste strategie permette di recuperare le posizioni perse e tornare a crescere nelle SERP.

In questa guida capiamo non solo cosa sono le penalizzazioni Google, ma anche cosa fare per risolvere.

Cosa sono le penalizzazioni Google?

Le penalizzazioni Google sono misure correttive applicate ai siti web che violano le linee guida stabilite dal motore di ricerca. Si tratta di sanzioni che comportano la perdita di posizionamento organico, fino alla completa rimozione dall’indice di Google nei casi più gravi.

Queste penalità nascono dall’esigenza di Google di garantire agli utenti risultati di ricerca pertinenti e di qualità. Quando un sito adotta tecniche manipolative o presenta contenuti che non rispettano gli standard richiesti, il motore di ricerca interviene per tutelare l’esperienza degli utenti.

Le conseguenze di una penalizzazione variano in base alla gravità della violazione. Un sito può perdere visibilità solo per alcune query specifiche oppure subire un declassamento generale che coinvolge l’intero dominio. In ogni caso, l’impatto sul traffico organico risulta immediato e significativo.

Tipologie di penalizzazioni: manuali vs algoritmiche

Google applica due tipologie distinte di penalizzazioni, che si differenziano per modalità di applicazione, visibilità e processo di recupero. Comprendere la differenza tra penalizzazioni manuali e algoritmiche è fondamentale per diagnosticare correttamente il problema e adottare la strategia di risoluzione più efficace.

Le penalizzazioni manuali vengono notificate esplicitamente attraverso Google Search Console, mentre quelle algoritmiche agiscono in modo silenzioso e richiedono un’analisi più approfondita per essere identificate. Entrambe le tipologie possono causare danni significativi al posizionamento, ma i tempi e le modalità di recupero seguono percorsi differenti.

Penalizzazioni manuali (azioni manuali)

Le azioni manuali sono penalizzazioni applicate direttamente dai quality rater di Google, membri del team che analizzano manualmente i siti web segnalati per presunte violazioni. Quando viene riscontrata una violazione delle linee guida, il team applica una sanzione specifica che può riguardare l’intero sito o singole pagine.

Il vantaggio principale delle penalizzazioni manuali è la trasparenza: Google notifica il problema attraverso la sezione “Azioni manuali” di Search Console, specificando la natura della violazione e fornendo indicazioni sulle aree da correggere. Le violazioni più comuni includono link innaturali in ingresso, thin content, spam generato dagli utenti e cloaking.

Una volta identificata e corretta la violazione, il webmaster può inviare una richiesta di riconsiderazione sempre tramite Search Console. Se le modifiche apportate sono adeguate e ben documentate, Google rimuove la penalizzazione e il sito può recuperare gradualmente le posizioni perse. I tempi di risposta variano da pochi giorni a diverse settimane, a seconda della complessità del caso.

Penalizzazioni algoritmiche

Le penalizzazioni algoritmiche vengono applicate automaticamente dagli algoritmi di Google durante la scansione e l’indicizzazione dei siti web. A differenza delle azioni manuali, non prevedono alcuna notifica diretta e risultano quindi più difficili da diagnosticare con certezza.

Queste penalità scattano quando un sito presenta caratteristiche che gli algoritmi identificano come violazioni delle linee guida. Gli algoritmi più noti includono Google Panda, focalizzato sulla qualità dei contenuti, Google Penguin, che analizza il profilo backlink, e i più recenti Core Updates e Helpful Content Update, che valutano la qualità complessiva e l’utilità dei contenuti per gli utenti.

Identificare una penalizzazione algoritmica richiede un’analisi incrociata tra calo del traffico e date degli aggiornamenti algoritmici. Il recupero non prevede richieste di riconsiderazione, ma passa attraverso la correzione dei problemi rilevati e l’attesa del successivo crawl o update algoritmico. Questo processo può richiedere settimane o mesi, rendendo il recupero da penalizzazioni algoritmiche generalmente più lungo rispetto a quelle manuali.

Come capire se il tuo sito è stato penalizzato

Riconoscere tempestivamente una penalizzazione permette di intervenire rapidamente e limitare i danni. Esistono diversi segnali che indicano la possibile presenza di una sanzione da parte di Google:

- Calo improvviso del traffico organico: una diminuzione drastica e repentina delle visite da ricerca organica, non giustificata da stagionalità o altri fattori esterni

- Perdita di posizionamento su keyword strategiche: scomparsa dalle prime posizioni o dalle prime pagine per le query più importanti del sito

- Riduzione delle impressioni in Search Console: diminuzione significativa del numero di volte in cui il sito appare nei risultati di ricerca

- Deindicizzazione di pagine: esclusione di intere sezioni o dell’intero dominio dall’indice di Google

- Notifiche in Google Search Console: messaggi espliciti nella sezione Azioni manuali o Sicurezza e azioni manuali

- Correlazione con aggiornamenti algoritmici: calo del traffico coincidente con il rilascio di Core Update o altri aggiornamenti

La gravità e la tipologia dei segnali aiutano a identificare se si tratta di una penalizzazione manuale o algoritmica, orientando così le azioni correttive necessarie.

Verifica penalizzazioni manuali con Google Search Console

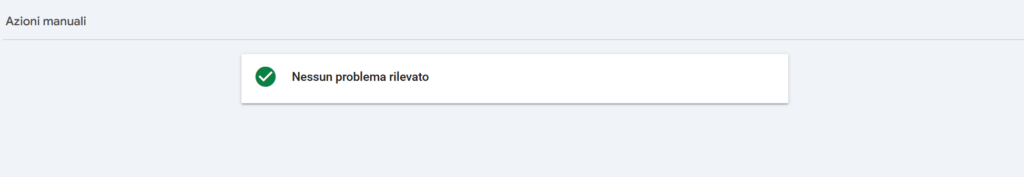

La diagnosi delle azioni manuali è relativamente semplice grazie alla trasparenza garantita da Google Search Console. Ecco la procedura completa per verificare la presenza di penalizzazioni manuali:

- Accedi a Google Search Console utilizzando l’account associato alla proprietà del sito web

- Seleziona la proprietà da verificare dal menu a tendina (se gestisci più siti)

- Nel menu laterale, clicca su “Sicurezza e azioni manuali” e poi su “Azioni manuali”

- Controlla lo stato visualizzato: se non ci sono problemi apparirà il messaggio “Nessun problema rilevato”

- In caso di penalizzazione, Google mostra la tipologia di violazione (ad esempio “Link innaturali verso il tuo sito”), la data di applicazione e le pagine o sezioni coinvolte

- Leggi attentamente la descrizione del problema fornita da Google, che include dettagli sulla violazione e suggerimenti per la risoluzione

Se viene rilevata un’azione manuale, è fondamentale documentare tutte le informazioni fornite prima di procedere con gli interventi correttivi. Queste indicazioni saranno essenziali per preparare la richiesta di riconsiderazione dopo aver risolto i problemi.

Come riconoscere una penalizzazione algoritmica

Identificare una penalizzazione algoritmica richiede un approccio analitico più sofisticato, poiché Google non invia notifiche dirette. Il primo passo consiste nel monitorare costantemente il traffico organico attraverso Google Analytics o altri strumenti di web analytics, prestando attenzione a cali significativi non spiegabili con variazioni stagionali o cambiamenti al sito.

La correlazione temporale con gli aggiornamenti algoritmici rappresenta l’indicatore più affidabile. Quando si registra un calo importante del traffico, è necessario verificare se coincide con il rilascio di un Core Update, Helpful Content Update o altri aggiornamenti noti. Strumenti come SEMrush, Ahrefs o SEOZoom offrono timeline degli update e permettono di confrontare l’andamento della visibilità con le date degli algoritmi.

L’analisi del posizionamento completa il quadro diagnostico.

Bisogna verificare quali pagine hanno perso posizioni, per quali keyword e se il declassamento riguarda l’intero sito o specifiche sezioni. Un calo generalizzato su contenuti di bassa qualità suggerisce un intervento di Panda o Helpful Content, mentre perdite concentrate su pagine con molti backlink artificiali indicano probabilmente Penguin. La raccolta sistematica di questi dati permette di formulare ipotesi precise sulla causa della penalizzazione e pianificare gli interventi correttivi più appropriati.

Debug dei cali di traffico: Penalizzazione o stagionalità?

Eseguire il debug dei cali di traffico è essenziale per capire se il tuo sito ha ricevuto una penalizzazione (manuale od algoritmica), oppure se abbiamo a che fare con cali stagionali, problemi tecnici, o altre anomalie.

Google ci fornisce una risorsa ottimale per fare un debug completo: dall’analisi dei dati storici del tuo sito fino al confronto con i trend del mercato.

Preferisci il formato video? Eccolo:

Principali cause delle penalizzazioni Google

Google penalizza i siti web che adottano pratiche contrarie alle sue linee guida, con l’obiettivo di mantenere alta la qualità dei risultati di ricerca. Conoscere le violazioni più comuni aiuta a evitare errori critici e a identificare rapidamente eventuali problemi sul proprio sito.

Contenuti di bassa qualità o duplicati

I contenuti di scarsa qualità rappresentano una delle cause più frequenti di penalizzazione algoritmica, specialmente dopo gli aggiornamenti Panda e Helpful Content Update. Google penalizza le pagine con thin content, ovvero contenuti scarni e privi di valore informativo, che non soddisfano l’intento di ricerca degli utenti.

La duplicazione dei contenuti costituisce un’altra violazione grave, che include il content scraping (copia da altri siti), la pubblicazione degli stessi testi su più pagine dello stesso dominio e l’uso di contenuti generati automaticamente senza supervisione umana. Google premia l’originalità e la capacità di fornire informazioni uniche e approfondite, penalizzando chi cerca scorciatoie attraverso la duplicazione o l’automazione di bassa qualità.

Dovresti farti questa domanda sulla qualità del tuo contenuto

Il tuo articolo o la tua pagina, sarebbero adatti alla pubblicazione enciclopedica o su rivista di settore? Se la risposta è no, probabilmente non meritano le prime posizioni su Google.

Link innaturali e schemi di link building

Il profilo backlink artificiale è tra le violazioni più monitorate da Google, specialmente dall’introduzione dell’algoritmo Penguin. La creazione di schemi di link finalizzati esclusivamente a manipolare il PageRank viene severamente penalizzata, inclusi l’acquisto di link a pagamento, l’uso di Private Blog Networks (PBN) e gli scambi massivi di link reciproci.

Anche l’ottimizzazione eccessiva degli anchor text rappresenta un segnale d’allarme: quando troppi backlink utilizzano esattamente la stessa keyword commerciale come testo di ancoraggio, Google interpreta il pattern come innaturale. Un profilo di link sano presenta varietà negli anchor text, con mix di branded, naked URL, generici e keyword parziali, riflettendo una crescita organica e spontanea della link popularity.

Keyword stuffing e sovra-ottimizzazione

Il keyword stuffing consiste nella ripetizione eccessiva e innaturale di parole chiave all’interno dei contenuti, con l’intento di manipolare il posizionamento. Questa pratica rende i testi difficilmente leggibili e compromette l’esperienza utente, andando contro i principi fondamentali di Google.

La sovra-ottimizzazione si manifesta anche attraverso l’uso forzato di keyword nei tag title, meta description, heading e attributi alt delle immagini, creando un pattern artificiale facilmente riconoscibile dagli algoritmi.

Google privilegia contenuti scritti in modo naturale, che utilizzano sinonimi, termini correlati e variazioni linguistiche, dimostrando una comprensione profonda dell’argomento trattato piuttosto che una mera ripetizione meccanica di parole chiave.

Cloaking e redirect ingannevoli

Il cloaking è una tecnica black hat che consiste nel mostrare contenuti diversi agli utenti rispetto a quelli presentati a Googlebot. Questa manipolazione viene utilizzata per far indicizzare al motore di ricerca pagine ottimizzate per il posizionamento, mentre gli utenti visualizzano contenuti completamente differenti, spesso di natura commerciale o spam.

I redirect ingannevoli includono reindirizzamenti che portano gli utenti verso pagine diverse da quelle indicate nei risultati di ricerca, senza una logica legittima. Mentre alcuni redirect sono accettabili (come il 301 per spostamenti permanenti o il cambio di dominio), Google penalizza quelli che servono solo a ingannare gli utenti o a manipolare il ranking, come i redirect sneaky o doorway pages che reindirizzano verso contenuti non correlati.

Testo e link nascosti

Il testo nascosto è una pratica che consiste nel rendere invisibili agli utenti contenuti o link attraverso tecniche CSS o HTML, mantenendoli però leggibili per i crawler. Metodi comuni includono l’uso di testo bianco su sfondo bianco, font-size a zero pixel, posizionamento di testo fuori dallo schermo con CSS o sovrapposizione di contenuti dietro immagini.

I link nascosti seguono la stessa logica manipolativa: vengono inseriti link invisibili agli utenti ma accessibili ai bot, con l’obiettivo di trasferire PageRank o manipolare il posizionamento. Google considera queste tecniche come tentativi deliberati di inganno e applica penalizzazioni severe, poiché violano il principio fondamentale di trasparenza e coerenza tra ciò che vedono gli utenti e i motori di ricerca.

Spam generato dagli utenti

Lo spam UGC (User Generated Content) riguarda i contenuti creati dagli utenti che non vengono adeguatamente moderati dal proprietario del sito. Commenti spam, messaggi nei forum, recensioni false e link inseriti in modo massivo dagli utenti possono generare penalizzazioni se non controllati.

Google considera il webmaster responsabile della qualità complessiva del sito, inclusi i contenuti generati dalla community. È fondamentale implementare sistemi di moderazione efficaci, utilizzare attributi nofollow sui link UGC, adottare sistemi CAPTCHA per prevenire bot automatici e rimuovere tempestivamente spam e contenuti inappropriati. L’assenza di controllo su sezioni aperte al pubblico può trasformare anche siti legittimi in veicoli di spam, con conseguenti penalizzazioni.

Sito compromesso o hackerato

Un sito compromesso rappresenta una minaccia sia per gli utenti che per la reputazione del dominio agli occhi di Google. Quando hacker iniettano contenuti malevoli, malware, phishing o spam farmaceutico attraverso vulnerabilità di sicurezza, Google può penalizzare il sito rimuovendolo dall’indice o mostrando avvisi di sicurezza nei risultati di ricerca.

Le compromissioni più comuni includono l’inserimento di pagine spam in lingua straniera (spesso giapponese o cirillico), redirect verso siti di phishing, iniezione di link nascosti e distribuzione di malware. Google Search Console notifica i problemi di sicurezza nella sezione dedicata, segnalando la presenza di contenuti compromessi. La risoluzione richiede la bonifica completa del sito, l’identificazione e correzione delle vulnerabilità sfruttate e la successiva richiesta di revisione a Google per rimuovere gli avvisi di sicurezza.

Principali algoritmi Google che causano penalizzazioni

Google utilizza diversi algoritmi specifici per valutare la qualità dei siti web e identificare violazioni delle linee guida. Conoscere i principali algoritmi e il loro focus permette di comprendere meglio le cause delle penalizzazioni algoritmiche e di orientare gli interventi correttivi in modo mirato.

Google Panda (Qualità dei contenuti)

Google Panda è l’algoritmo dedicato alla valutazione della qualità dei contenuti, lanciato nel 2011 e successivamente integrato nell’algoritmo core di Google. Panda analizza numerosi fattori per determinare se una pagina offre valore reale agli utenti o rappresenta contenuto di bassa qualità.

L’algoritmo penalizza principalmente i thin content (contenuti scarni e superficiali), le pagine duplicate o con alto tasso di duplicazione, i contenuti generati automaticamente senza supervisione umana e i siti con elevate percentuali di pubblicità rispetto al contenuto editoriale. Panda valuta anche metriche comportamentali come il tempo di permanenza sulla pagina e la frequenza di rimbalzo, che indicano il livello di soddisfazione degli utenti.

Le penalizzazioni Panda possono riguardare singole pagine o intere sezioni del sito, ma nei casi più gravi colpiscono l’intero dominio quando la bassa qualità è diffusa. Il recupero richiede un miglioramento sostanziale dei contenuti, con l’aggiunta di informazioni approfondite, l’eliminazione delle pagine di scarso valore e l’implementazione di un approccio editoriale orientato alla qualità piuttosto che alla quantità.

Google Penguin (Profilo backlink)

Google Penguin, introdotto nel 2012 e diventato parte dell’algoritmo core nel 2016, si concentra sull’analisi del profilo backlink per identificare schemi di link building innaturali. L’obiettivo è penalizzare i siti che cercano di manipolare il ranking attraverso l’acquisizione artificiale di backlink.

Penguin colpisce duramente i link spam, inclusi i link provenienti da network privati di blog (PBN), i link a pagamento non contrassegnati come nofollow, gli scambi massicci di link reciproci e i link da directory di bassa qualità. L’algoritmo è particolarmente sensibile ai pattern sospetti negli anchor text, penalizzando profili con percentuali anomale di anchor text commerciali esatti.

A differenza di Panda, Penguin tende ad applicare penalizzazioni più granulari, colpendo specifiche pagine o keyword piuttosto che l’intero sito. Dal momento in cui è diventato real-time, Penguin aggiorna i suoi filtri con ogni nuovo crawl, permettendo recuperi più rapidi una volta ripulito il profilo backlink attraverso la rimozione di link tossici o l’uso del Disavow Tool.

Core Updates e Helpful Content Update

I Core Updates sono aggiornamenti ampi e generali dell’algoritmo di ranking di Google, rilasciati più volte all’anno senza un focus specifico su una singola tipologia di violazione. Questi update valutano la qualità complessiva dei siti web considerando centinaia di fattori, dalla rilevanza dei contenuti all’autorevolezza del dominio, dall’esperienza utente alla freschezza delle informazioni.

L’Helpful Content Update, introdotto nel 2023 e successivamente integrato nei Core Updates, rappresenta un’evoluzione significativa nella valutazione dei contenuti. Questo algoritmo premia i contenuti creati principalmente per gli utenti e penalizza quelli realizzati esclusivamente per i motori di ricerca. Valuta se i contenuti dimostrano expertise reale, se forniscono valore aggiunto rispetto ad altre risorse disponibili e se soddisfano pienamente l’intento di ricerca.

Gli update più recenti enfatizzano il concetto di E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness), richiedendo che i contenuti siano creati da autori con esperienza diretta e competenze dimostrabili nel settore trattato. I siti colpiti da questi aggiornamenti devono ripensare completamente la propria strategia di content, focalizzandosi sulla creazione di risorse davvero utili piuttosto che sulla produzione di volume per intercettare traffico.

Come uscire da una penalizzazione Google

Il recupero da una penalizzazione richiede un approccio sistematico e paziente, con strategie diverse a seconda che si tratti di un’azione manuale o algoritmica. In entrambi i casi, è fondamentale identificare con precisione le cause, implementare correzioni complete e monitorare costantemente i risultati.

Recupero da penalizzazione manuale

Il processo di recupero da un’azione manuale segue una procedura strutturata in quattro fasi principali:

- Identificare la violazione: Accedere a Google Search Console, sezione Azioni manuali, e leggere attentamente la descrizione del problema fornita da Google. Prendere nota della tipologia di violazione, delle pagine coinvolte e di eventuali esempi specifici indicati nel messaggio.

- Correggere il problema: Risolvere completamente la violazione identificata. Per link innaturali, rimuovere o ottenere l’attributo nofollow su tutti i backlink artificiali; per thin content, migliorare sostanzialmente i contenuti o rimuovere le pagine di scarso valore; per spam UGC, eliminare tutti i contenuti spam e implementare sistemi di moderazione; per cloaking, allineare i contenuti mostrati agli utenti con quelli serviti ai crawler.

- Documentare le modifiche: Creare una documentazione dettagliata di tutti gli interventi effettuati. Includere liste di URL modificati o rimossi, esempi concreti di miglioramenti apportati, elenchi di link rimossi con relative conferme dai webmaster o utilizzo del Disavow Tool. La documentazione deve dimostrare la comprensione del problema e l’impegno nella sua risoluzione completa.

- Inviare richiesta di riconsiderazione: Tramite la sezione Azioni manuali in Search Console, compilare il modulo di richiesta di riconsiderazione spiegando in modo chiaro e onesto cosa è stato fatto per risolvere il problema. Allegare la documentazione preparata, evitare giustificazioni vaghe e dimostrare che sono state prese misure per prevenire future violazioni.

Google elabora le richieste di riconsiderazione in tempi variabili, da pochi giorni a diverse settimane. Se la richiesta viene accettata, l’azione manuale viene rimossa e il sito può gradualmente recuperare posizioni. Se viene rifiutata, significa che il problema non è stato risolto completamente: è necessario analizzare nuovamente la violazione, apportare ulteriori correzioni e inviare una nuova richiesta più dettagliata.

Recupero da penalizzazione algoritmica

Il recupero da una penalizzazione algoritmica richiede un approccio più complesso e tempi generalmente più lunghi, poiché non esiste un feedback diretto da Google:

Audit approfondito: Il primo passo consiste nell’analisi completa del sito per identificare tutti i fattori che potrebbero aver causato la penalizzazione. Per sospette penalizzazioni Panda, condurre un’analisi della qualità dei contenuti pagina per pagina, identificando thin content, duplicazioni e pagine di scarso valore. Per Penguin, eseguire un audit completo del profilo backlink utilizzando Google Search Console, Ahrefs, SEMrush o Majestic, classificando ogni link come naturale, sospetto o tossico. Per Core Updates o Helpful Content, valutare l’allineamento complessivo del sito con i principi E-E-A-T e verificare se i contenuti soddisfano realmente l’intento di ricerca.

Interventi correttivi: Implementare modifiche sostanziali basate sull’audit. Migliorare o rimuovere contenuti di bassa qualità, consolidare pagine duplicate, arricchire contenuti superficiali con informazioni approfondite e originali. Ripulire il profilo backlink contattando webmaster per rimuovere link innaturali e utilizzare il Disavow Tool per i link non rimovibili. Migliorare l’esperienza utente, ottimizzare la velocità di caricamento, rendere il sito mobile-friendly e implementare segnali di autorevolezza come bio degli autori e referenze.

Attesa e monitoraggio: Dopo aver implementato le correzioni, è necessario attendere che Googlebot esegua il recrawl delle pagine modificate e che venga rilasciato il prossimo aggiornamento dell’algoritmo specifico che ha causato la penalizzazione. Questo processo può richiedere settimane o mesi. Durante l’attesa, monitorare costantemente traffico organico, posizionamenti e impressioni in Search Console, documentando ogni variazione significativa.

Iterazione: Se dopo l’aggiornamento algoritmico successivo non si registrano miglioramenti, significa che le correzioni non sono state sufficienti. È necessario approfondire ulteriormente l’analisi, identificare problemi non risolti e implementare interventi aggiuntivi, ripetendo il ciclo fino al recupero completo.

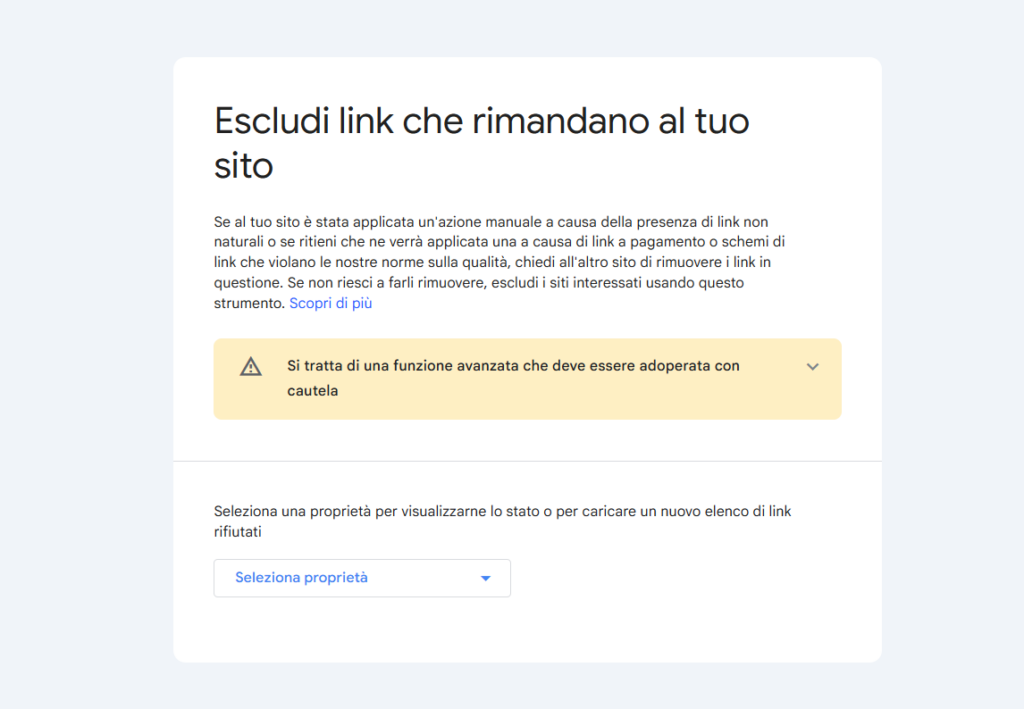

Come utilizzare il Disavow Tool

Il Disavow Tool è uno strumento di Google Search Console che permette di segnalare backlink indesiderati che potrebbero danneggiare il profilo link del sito. Si tratta di un’opzione da utilizzare con cautela, solo dopo aver tentato senza successo la rimozione diretta dei link problematici.

Quando usarlo

Il Disavow Tool è appropriato quando si è ricevuta un’azione manuale per “Link innaturali verso il tuo sito”, quando si sospetta una penalizzazione Penguin dovuta a link tossici ereditati da attività passate o da attacchi SEO negativi, o quando è impossibile ottenere la rimozione di link spam nonostante ripetuti tentativi di contatto con i webmaster. Non utilizzarlo preventivamente su tutti i link di bassa qualità, poiché Google è generalmente in grado di ignorarli autonomamente.

Come creare il file

Preparare un file di testo (.txt) contenente l’elenco dei link o domini da rifiutare. Il formato prevede un URL o dominio per riga. Per rifiutare singoli URL, inserire l’indirizzo completo (esempio: https://spam-site.com/bad-page). Per rifiutare interi domini, utilizzare il prefisso domain: seguito dal dominio (esempio: domain:spam-site.com). È possibile aggiungere commenti preceduti dal simbolo # per documentare le ragioni del disavow.

Procedura di caricamento: Accedere a Google Search Console, selezionare la proprietà, andare nella sezione Disavow Links Tool (cercandolo nel menu o tramite URL diretto). Caricare il file .txt preparato e confermare l’operazione. Google elabora il file durante i successivi crawl, quindi gli effetti non sono immediati ma richiedono settimane.

Avvertenze importanti: Il Disavow Tool è un’arma a doppio taglio. Un uso scorretto può danneggiare link naturali e positivi, peggiorando il posizionamento anziché migliorarlo. Prima di utilizzarlo, è fondamentale effettuare un’analisi accurata del profilo backlink, distinguendo con certezza i link tossici da quelli legittimi. Documentare sempre i motivi per cui si considera ogni link negativo e mantenere un backup del file caricato. In caso di dubbi, consultare un esperto SEO prima di procedere.

Tempi di recupero dopo una penalizzazione

I tempi necessari per recuperare da una penalizzazione variano significativamente in base alla tipologia di sanzione, alla gravità della violazione e alla qualità degli interventi correttivi. Comprendere le tempistiche realistiche aiuta a gestire le aspettative e a pianificare la strategia di recupero.

Per le penalizzazioni manuali, i tempi sono generalmente più prevedibili. Una volta corretta la violazione e inviata la richiesta di riconsiderazione, Google impiega mediamente da 3 a 15 giorni lavorativi per elaborare la richiesta e fornire una risposta. Se la richiesta viene accettata, la rimozione dell’azione manuale è immediata, ma il recupero effettivo delle posizioni nei risultati di ricerca avviene gradualmente nel corso delle successive 2-4 settimane, man mano che Googlebot esegue il recrawl delle pagine e ricalcola il ranking. In caso di rigetto, è necessario apportare ulteriori correzioni e inviare una nuova richiesta, allungando i tempi complessivi.

Le penalizzazioni algoritmiche richiedono tempi significativamente più lunghi e meno prevedibili. Dopo aver implementato le correzioni, è necessario attendere che Googlebot esegua il crawl completo delle modifiche, processo che può richiedere da alcune settimane a diversi mesi a seconda delle dimensioni del sito e della frequenza di crawl. Il recupero effettivo avviene solo con il successivo aggiornamento dell’algoritmo specifico che ha causato la penalizzazione: per algoritmi integrati nel core come Panda e Penguin, i miglioramenti possono manifestarsi con ogni nuovo crawl, mentre per altri update specifici può essere necessario attendere il rilascio programmato successivo, che per i Core Updates avviene mediamente ogni 3-4 mesi.

I casi più complessi, come siti fortemente compromessi da contenuti di bassa qualità diffusi o profili backlink gravemente compromessi, possono richiedere 6-12 mesi per un recupero completo. In questi scenari, spesso sono necessari interventi progressivi e iterativi, con miglioramenti graduali che si manifestano attraverso più cicli di aggiornamento algoritmico. La costanza negli interventi di qualità e il monitoraggio continuo dei risultati rappresentano la chiave per accelerare il processo di recupero.

Come prevenire le penalizzazioni Google

Adottare un approccio preventivo rappresenta la strategia più efficace per evitare penalizzazioni e mantenere stabilità nel posizionamento organico. Le best practice si basano sul rispetto delle linee guida Google e sulla creazione di valore reale per gli utenti:

- Creare contenuti originali e di qualità: Pubblicare esclusivamente contenuti unici, approfonditi e ben ricercati che rispondano completamente all’intento di ricerca degli utenti, evitando duplicazioni, thin content e contenuti generati automaticamente senza supervisione

- Costruire un profilo backlink naturale: Ottenere link attraverso la creazione di contenuti meritevoli, digital PR e relazioni autentiche, evitando schemi di link building, acquisto di link, PBN e scambi massicci di link reciproci

- Seguire le linee guida Search Essentials: Consultare regolarmente la documentazione ufficiale di Google per rimanere aggiornati sulle pratiche consigliate e sulle violazioni da evitare

- Ottimizzare senza sovra-ottimizzare: Utilizzare le keyword in modo naturale e contestuale, evitando keyword stuffing, ripetizioni forzate e anchor text sovra-ottimizzati

- Garantire trasparenza e coerenza: Mostrare sempre gli stessi contenuti agli utenti e ai crawler, evitando cloaking, testo nascosto, redirect ingannevoli e doorway pages

- Moderare i contenuti generati dagli utenti: Implementare sistemi di moderazione efficaci per commenti, recensioni e forum, utilizzando attributi nofollow sui link UGC e rimuovendo tempestivamente spam e contenuti inappropriati

- Mantenere la sicurezza del sito: Aggiornare regolarmente CMS, plugin e temi, utilizzare password robuste, implementare certificati SSL e monitorare il sito per rilevare tempestivamente eventuali compromissioni

- Monitorare costantemente le performance: Tenere sotto controllo traffico organico, posizionamenti e notifiche in Search Console per identificare rapidamente anomalie o problemi emergenti

- Evitare tecniche black hat: Rifiutare qualsiasi strategia che prometta risultati rapidi attraverso scorciatoie o manipolazioni, privilegiando sempre un approccio white hat orientato al lungo termine

- Investire nell’esperienza utente: Ottimizzare velocità di caricamento, rendere il sito mobile-friendly, migliorare la navigazione e creare un’architettura informativa chiara e accessibile

- Dimostrare autorevolezza e competenza: Implementare segnali E-E-A-T attraverso bio degli autori con credenziali verificabili, citazioni di fonti autorevoli, recensioni genuine e testimonianze autentiche

- Aggiornare regolarmente i contenuti: Mantenere fresche le informazioni, aggiornare dati obsoleti, rimuovere contenuti non più rilevanti e arricchire progressivamente le risorse esistenti

Strumenti utili per monitorare e prevenire penalizzazioni

Utilizzare gli strumenti giusti permette di identificare tempestivamente problemi potenziali e monitorare efficacemente lo stato di salute del sito. Una combinazione di strumenti gratuiti e professionali offre la visibilità necessaria per prevenire e diagnosticare penalizzazioni.

- Google Search Console rappresenta lo strumento fondamentale e imprescindibile per ogni webmaster. Offre accesso diretto alle notifiche di azioni manuali, permette di monitorare le performance di ricerca con dati su impressioni, clic e posizionamento medio, identifica problemi di indicizzazione e copertura, segnala errori di sicurezza e contenuti compromessi, e consente l’invio di richieste di riconsiderazione. La sezione “Miglioramenti” evidenzia inoltre problemi relativi a Core Web Vitals, usabilità mobile e dati strutturati.

- Google Analytics fornisce dati essenziali sul comportamento degli utenti e sull’andamento del traffico. Permette di monitorare il traffico organico nel tempo, identificando cali improvvisi che potrebbero indicare penalizzazioni, analizzare metriche comportamentali come frequenza di rimbalzo e tempo di permanenza che riflettono la qualità dei contenuti, confrontare le performance tra diverse sezioni del sito per identificare aree problematiche, e segmentare il traffico per fonte, dispositivo e pagina di destinazione.

- SEMrush è una piattaforma completa per il monitoraggio SEO che offre tracking del posizionamento giornaliero per keyword strategiche, analisi del profilo backlink con identificazione di link tossici, audit automatici del sito che evidenziano problemi tecnici e di contenuto, storico della visibilità correlato con le date degli aggiornamenti algoritmici, e strumenti di competitive analysis per confrontare le performance con i concorrenti.

- Ahrefs eccelle nell’analisi dei backlink, fornendo uno dei database più completi e aggiornati disponibili. Permette di monitorare nuovi link acquisiti e link persi, valutare la qualità dei domini linkanti attraverso metriche proprietarie, identificare anchor text sovra-ottimizzati o pattern sospetti, scoprire link tossici che potrebbero causare penalizzazioni Penguin, e analizzare il profilo backlink dei concorrenti per benchmark di qualità.

- Screaming Frog SEO Spider è uno strumento tecnico per l’audit approfondito che esegue crawl completi del sito identificando contenuti duplicati, problemi di thin content, errori di redirect e catene di reindirizzamento, link rotti interni ed esterni, problemi con tag title e meta description, e anomalie strutturali che potrebbero impattare il posizionamento.

- SEOZoom è uno strumento italiano completo che combina funzionalità di rank tracking, analisi backlink, audit tecnico e monitoraggio della competizione, con un’attenzione specifica al mercato italiano e alle peculiarità delle SERP locali.

- PageSpeed Insights e Core Web Vitals report in Search Console sono essenziali per monitorare le performance tecniche del sito, sempre più rilevanti nel ranking di Google dopo l’introduzione del Page Experience Update.

La combinazione strategica di questi strumenti, utilizzati con costanza e interpretati correttamente, permette di costruire un sistema di monitoraggio efficace che identifica problemi prima che degenerino in penalizzazioni e fornisce i dati necessari per interventi correttivi tempestivi.