La SEO tecnica rappresenta il fondamento invisibile ma essenziale per il successo di qualsiasi strategia di posizionamento sui motori di ricerca. Mentre i contenuti di qualità attirano l’attenzione degli utenti, è l’ottimizzazione tecnica che permette ai crawler di Google di accedere, scansionare e indicizzare correttamente le pagine del sito.

Senza una solida base tecnica, anche i contenuti migliori rischiano di rimanere invisibili nei risultati di ricerca, compromettendo visibilità e performance organiche. Scopriamo di più sulla SEO tecnica, sulla sua importanza e su quali sono le aree di intervento da tenere sotto controllo.

Cos’è la SEO Tecnica?

La SEO tecnica è l’insieme di attività e ottimizzazioni che riguardano l’infrastruttura e gli aspetti tecnologici di un sito web, finalizzate a facilitare la scansione, l’indicizzazione e la comprensione dei contenuti da parte dei motori di ricerca. Si tratta della componente che opera “dietro le quinte”, assicurando che il sito risponda ai requisiti tecnici richiesti da Google e dagli altri search engine per garantire un posizionamento ottimale.

A differenza della SEO on-page, che si concentra sull’ottimizzazione dei contenuti visibili (testi, meta tag, immagini, keyword), e della SEO off-page, che riguarda le attività esterne al sito come link building e brand reputation, la SEO tecnica interviene sulla struttura, sul codice e sulle configurazioni del server. In pratica, la SEO tecnica crea le condizioni ideali affinché Googlebot possa navigare efficacemente il sito, comprenderne l’architettura e valutare correttamente la qualità e la rilevanza delle pagine.

Gli ambiti di intervento spaziano dalla velocità di caricamento all’architettura informativa, dalla gestione dei file di configurazione come robots.txt e sitemap XML alla corretta implementazione dei protocolli di sicurezza HTTPS. Ogni elemento tecnico ottimizzato contribuisce a migliorare la comunicazione tra il sito e i motori di ricerca, riducendo gli ostacoli che potrebbero impedire una corretta indicizzazione.

Perché la SEO Tecnica è Importante per il Posizionamento

L’ottimizzazione tecnica non è un aspetto secondario della strategia SEO, ma un prerequisito fondamentale che influenza direttamente il ranking e la visibilità organica. I motori di ricerca premiano i siti che offrono un’esperienza utente superiore e che facilitano il lavoro dei crawler, rendendo la SEO tecnica un fattore competitivo determinante.

I principali vantaggi dell’ottimizzazione tecnica includono:

- Miglioramento della crawlability: un sito tecnicamente ottimizzato permette a Googlebot di scansionare più pagine in modo efficiente, massimizzando il crawl budget disponibile

- Indicizzazione completa e corretta: eliminando errori tecnici e contenuti duplicati, si garantisce che tutte le pagine importanti vengano indicizzate correttamente

- Velocità e performance superiori: siti più veloci offrono una migliore user experience e ricevono un boost nel ranking, specialmente dopo l’introduzione dei Core Web Vitals come fattore di posizionamento

- Vantaggio competitivo su mobile: l’ottimizzazione mobile-first risponde all’indicizzazione prioritaria di Google per dispositivi mobili, fondamentale considerando che oltre il 60% del traffico web proviene da smartphone

- Riduzione del tasso di rimbalzo: un sito tecnicamente performante carica rapidamente e funziona senza intoppi, trattenendo gli utenti più a lungo

- Maggiore sicurezza e fiducia: l’implementazione di HTTPS non solo è un fattore di ranking confermato da Google, ma aumenta la fiducia degli utenti

- Rich snippet e visibilità aumentata: l’implementazione corretta dei dati strutturati può generare risultati arricchiti nelle SERP, aumentando il CTR organico

Aree di Intervento della SEO Tecnica

La SEO tecnica abbraccia numerose aree di ottimizzazione che lavorano sinergicamente per garantire le migliori performance possibili. Ogni ambito richiede competenze specifiche e interventi mirati, dalla configurazione del server alla gestione del codice, dall’architettura informativa all’ottimizzazione delle performance.

Le principali aree di intervento includono la crawlability e la scansione del sito, l’indicizzazione e la gestione dei contenuti, la velocità e le performance, l’ottimizzazione mobile-first, l’architettura del sito e la struttura degli URL, la sicurezza con protocollo HTTPS, l’implementazione dei dati strutturati, la gestione degli errori e dei redirect, e l’ottimizzazione del rendering JavaScript. Ciascuna di queste aree contribuisce a costruire un ecosistema tecnico solido che supporta e amplifica l’efficacia delle altre strategie SEO, creando le condizioni ideali per un posizionamento duraturo e competitivo.

Crawlability e Scansione del Sito

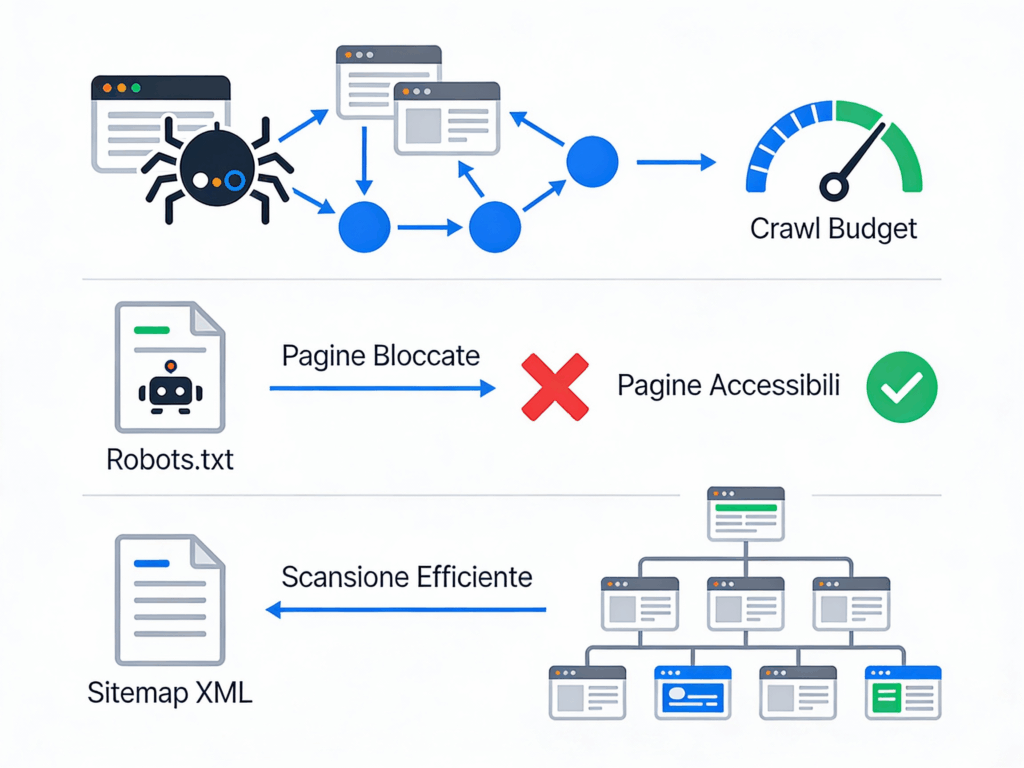

La crawlability è la capacità di un sito web di essere scansionato efficacemente dai bot dei motori di ricerca, in particolare da Googlebot. Quando un crawler visita un sito, segue i link interni per scoprire nuove pagine, analizza il contenuto e raccoglie informazioni da inviare all’indice di Google.

Un sito con elevata crawlability permette ai bot di accedere facilmente a tutte le pagine importanti, navigare attraverso la struttura senza ostacoli e completare la scansione in modo efficiente.

Problemi di crawlability, come link rotti, blocchi nel file robots.txt o architetture troppo profonde, possono impedire l’indicizzazione di pagine strategiche e compromettere seriamente il posizionamento organico.

Crawl Budget e Ottimizzazione

Il crawl budget rappresenta il numero di pagine che Googlebot è disposto a scansionare su un sito web in un determinato periodo di tempo.

Questo “budget” non è infinito e varia in base a diversi fattori, tra cui l’autorevolezza del dominio, la velocità del server, la qualità dei contenuti e la frequenza di aggiornamento. Per i siti di piccole-medie dimensioni (fino a qualche migliaio di pagine), il crawl budget raramente rappresenta un problema, ma per portali con decine o centinaia di migliaia di URL diventa un fattore critico da ottimizzare.

Per massimizzare l’efficienza del crawl budget è fondamentale eliminare pagine di basso valore come risultati di ricerca interna, pagine di filtri parametrici, contenuti duplicati e URL generati dinamicamente senza valore SEO.

Utilizzare il tag canonical per consolidare pagine simili, bloccare tramite robots.txt le sezioni non rilevanti (come pannelli admin o script), e mantenere una velocità del server ottimale per permettere ai bot di scansionare più pagine in meno tempo sono pratiche essenziali. Monitorare regolarmente i report di scansione in Google Search Console aiuta a identificare errori, pagine bloccate e problematiche che consumano crawl budget inutilmente.

File Robots.txt

Il file robots.txt è un documento di testo che risiede nella root del dominio e fornisce istruzioni ai crawler sui contenuti che possono o non possono scansionare. Funziona come un “guardiano” che regola l’accesso dei bot alle diverse sezioni del sito. Un robots.txt configurato correttamente previene lo spreco di crawl budget su aree non strategiche e protegge contenuti sensibili o duplicati dall’indicizzazione.

La sintassi base include direttive come User-agent (specifica quale bot riceve le istruzioni), Disallow (blocca l’accesso a URL o directory specifiche) e Allow (permette eccezioni alle regole Disallow). Ad esempio, per bloccare l’accesso alla cartella admin a tutti i crawler si utilizza: User-agent: * Disallow: /admin/.

È importante includere anche la direttiva Sitemap per indicare la posizione della sitemap XML, facilitando la scoperta delle pagine da parte dei motori di ricerca.

Errori comuni da evitare includono il blocco accidentale di pagine importanti, l’uso di sintassi errata che invalida l’intero file, e il blocco di risorse CSS o JavaScript che impediscono a Google di renderizzare correttamente le pagine. Testare sempre il robots.txt con lo strumento di Google Search Console prima di metterlo in produzione.

Sitemap XML

La sitemap XML è un file strutturato che elenca tutte le URL importanti di un sito web, fornendo ai motori di ricerca una “mappa” completa dei contenuti da scansionare. Mentre i crawler possono scoprire pagine seguendo i link interni, la sitemap garantisce che anche pagine meno linkate o recentemente pubblicate vengano trovate rapidamente, accelerando il processo di indicizzazione.

Una sitemap ben strutturata include non solo gli URL ma anche metadati utili come la data dell’ultimo aggiornamento (lastmod), la frequenza di modifica (changefreq) e la priorità relativa delle pagine (priority). Per siti di grandi dimensioni è consigliabile creare sitemap multiple organizzate per sezioni o tipologie di contenuto, mantenendo ogni file sotto i 50MB e 50.000 URL come da limiti consigliati da Google.

Best practice per la creazione includono: inserire solo URL canoniche (evitare redirect e duplicati), escludere pagine bloccate da robots.txt o con noindex, aggiornare automaticamente la sitemap quando vengono pubblicate nuove pagine, e sottoporre la sitemap a Google Search Console per monitorare lo stato di indicizzazione.

Per siti dinamici che pubblicano contenuti frequentemente, implementare sitemap dinamiche generate automaticamente dal CMS è essenziale per mantenere l’indice sempre aggiornato.

Indicizzazione e Gestione dei Contenuti

L’indicizzazione è il processo attraverso cui i motori di ricerca analizzano, elaborano e memorizzano i contenuti scansionati nel proprio database, rendendoli disponibili per le query degli utenti.

Anche se Googlebot riesce a scansionare un sito, questo non garantisce automaticamente l’indicizzazione: pagine con contenuti duplicati, di bassa qualità o con direttive di esclusione non entreranno nell’indice.

Gestire correttamente l’indicizzazione significa assicurarsi che solo le pagine di valore vengano incluse, evitando problemi di cannibalizzazione, duplicazione e dispersione del ranking.

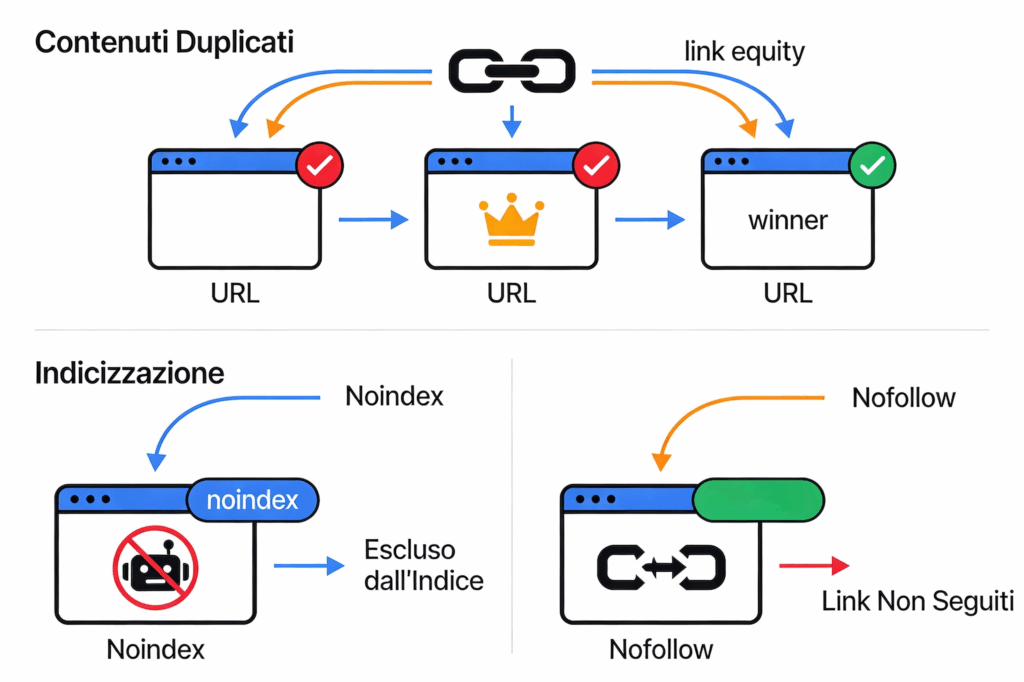

Contenuti Duplicati e Tag Canonical

I contenuti duplicati rappresentano una delle problematiche tecniche più comuni e insidiose per la SEO. Si verificano quando lo stesso contenuto (o molto simile) è accessibile attraverso URL diversi, generando confusione nei motori di ricerca che non sanno quale versione privilegiare nei risultati.

Questa situazione può emergere per varie ragioni: versioni www e non-www del dominio, parametri URL per tracciamento o filtri, versioni stampabili delle pagine, o paginazione mal gestita.

Il tag canonical (rel=”canonical”) è lo strumento principale per risolvere questi problemi, indicando a Google quale sia la versione “ufficiale” di una pagina tra diverse varianti. Implementato nell’header HTML della pagina duplicata, punta verso l’URL canonico che si desidera indicizzare: <link rel="canonical" href="https://esempio.it/pagina-originale/" />. Questo consolida i segnali di ranking sull’URL principale, evitando la dispersione di autorevolezza tra varianti duplicate.

È fondamentale utilizzare il canonical in modo coerente (gli URL canonici devono puntare sempre a se stessi), evitare catene di canonical (A→B→C), e assicurarsi che l’URL canonico sia effettivamente accessibile e restituisca un codice 200.

Per verificare problemi di duplicazione, strumenti come Screaming Frog o Google Search Console (sezione Indicizzazione→Pagine) aiutano a identificare pagine con contenuti simili o canonical errati che richiedono interventi correttivi.

Meta Tag Noindex e Nofollow

I meta tag robots permettono un controllo granulare sull’indicizzazione e sul crawling a livello di singola pagina. Il meta tag noindex (<meta name="robots" content="noindex">) istruisce i motori di ricerca a non includere la pagina nell’indice, anche se possono comunque scansionarla e seguire i link presenti. Questo è utile per escludere pagine di basso valore SEO come pagine di ringraziamento, risultati di ricerca interna, aree riservate agli utenti registrati o contenuti stagionali non più rilevanti.

Il tag nofollow (<meta name="robots" content="nofollow">) invece indica ai crawler di non seguire nessuno dei link presenti nella pagina, interrompendo il flusso di PageRank. È importante distinguere tra il nofollow a livello di pagina (meta tag) e quello a livello di singolo link (attributo rel=”nofollow” sull’anchor tag), che ha applicazioni diverse. Raramente si utilizza noindex insieme a nofollow, poiché impedire il crawling dei link può bloccare la scoperta di altre pagine importanti.

Situazioni comuni per l’uso di noindex includono: pagine duplicate che non possono essere risolte con canonical, pagine con contenuti thin o generati automaticamente, archivi per data nei blog, pagine di paginazione (se non gestite con rel=”next” e “prev”), e landing page a pagamento che non devono competere con i risultati organici.

Verificare l’implementazione corretta tramite il codice sorgente o strumenti SEO spider è cruciale, poiché un noindex accidentale su pagine strategiche può causare perdite significative di traffico organico.

Velocità e Performance del Sito

La velocità di caricamento è diventata uno dei fattori di ranking più rilevanti per Google, oltre a influenzare direttamente l’esperienza utente e i tassi di conversione. Studi dimostrano che ogni secondo di ritardo nel caricamento può ridurre significativamente le conversioni e aumentare il tasso di abbandono.

Dal 2021, con l’introduzione dei Core Web Vitals come segnali ufficiali di ranking, Google ha reso la performance una priorità assoluta per il posizionamento organico. Un sito lento non solo frustra gli utenti ma viene anche penalizzato nei risultati di ricerca, perdendo visibilità a favore di competitor più veloci. L’ottimizzazione delle performance richiede un approccio olistico che include la riduzione del peso delle risorse, l’ottimizzazione del codice, l’uso efficiente del server e l’implementazione di tecniche di caching avanzate.

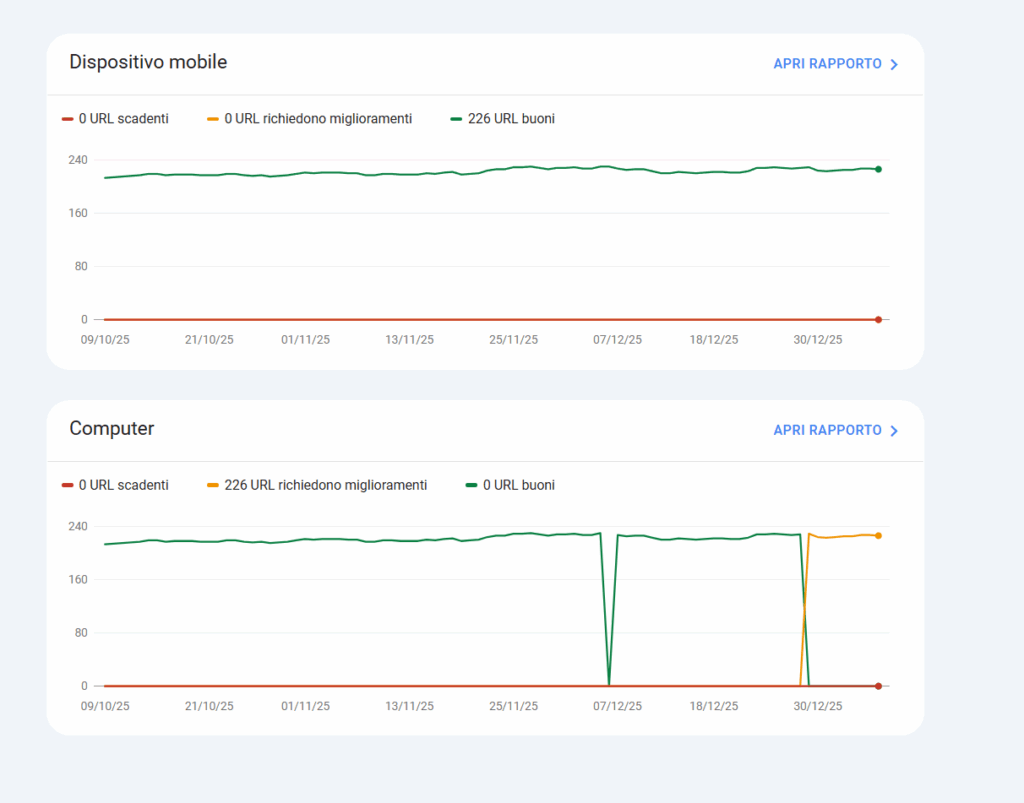

Core Web Vitals

I Core Web Vitals sono un insieme di tre metriche specifiche definite da Google per misurare oggettivamente la qualità dell’esperienza utente in termini di velocità, reattività e stabilità visiva. Questi parametri sono diventati parte integrante del “Page Experience” update e rappresentano criteri fondamentali per valutare le performance tecniche di un sito.

Il Largest Contentful Paint (LCP) misura il tempo necessario per caricare l’elemento più grande visibile nell’area above-the-fold della pagina, che può essere un’immagine, un video o un blocco di testo. Google considera ottimale un LCP inferiore a 2,5 secondi, accettabile tra 2,5 e 4 secondi, e da migliorare oltre i 4 secondi. Per ottimizzare l’LCP è essenziale ridurre i tempi di risposta del server, eliminare risorse che bloccano il rendering, ottimizzare le immagini hero e implementare il preloading per le risorse critiche.

L’Interaction to Next Paint (INP) ha sostituito il First Input Delay nel 2024 e valuta la reattività complessiva della pagina misurando il tempo tra l’interazione dell’utente (click, tap, input) e l’aggiornamento visivo successivo. Un INP ottimale dovrebbe essere inferiore a 200 millisecondi, mentre valori superiori a 500ms indicano problemi gravi di reattività. JavaScript pesante e operazioni di rendering complesse sono i principali responsabili di INP elevati.

Il Cumulative Layout Shift (CLS) quantifica la stabilità visiva misurando gli spostamenti inaspettati degli elementi durante il caricamento della pagina. Un punteggio CLS inferiore a 0,1 è considerato buono, mentre valori superiori a 0,25 creano un’esperienza utente frustrante. Problemi comuni includono immagini senza dimensioni specificate, font web che causano FOIT/FOUT, e contenuti dinamici inseriti sopra contenuti esistenti. Specificare sempre altezza e larghezza per immagini e video, riservare spazio per banner pubblicitari e evitare inserimenti dinamici che spostano il contenuto sono pratiche essenziali.

Ottimizzazione delle Immagini

Le immagini rappresentano spesso la maggior parte del peso totale di una pagina web, rendendole il principale target per l’ottimizzazione delle performance. Un’immagine pesante può rallentare drasticamente il caricamento e compromettere i Core Web Vitals, specialmente l’LCP se l’immagine è above-the-fold.

I formati moderni come WebP e AVIF offrono una compressione superiore rispetto ai tradizionali JPEG e PNG, riducendo le dimensioni dei file del 25-35% senza perdita visibile di qualità. WebP è ormai supportato da tutti i browser moderni e rappresenta lo standard consigliato, mentre AVIF offre compressione ancora migliore ma con supporto browser meno universale. Utilizzare l’elemento <picture> con fallback permette di servire formati moderni ai browser compatibili mantenendo la retrocompatibilità.

Tecniche di ottimizzazione efficaci includono la compressione (sia lossy che lossless a seconda del caso d’uso), il responsive sizing per servire dimensioni appropriate a ciascun dispositivo tramite attributi srcset e sizes, e il lazy loading per caricare immagini fuori viewport solo quando l’utente scrolla. L’attributo loading="lazy" nativo HTML è ora supportato universalmente e dovrebbe essere applicato a tutte le immagini non critiche. Per immagini above-the-fold invece è essenziale specificare dimensioni esplicite e considerare il preloading con <link rel="preload"> per migliorare l’LCP.

Minificazione di CSS e JavaScript

La minificazione è il processo di rimozione di caratteri non necessari dal codice sorgente (spazi bianchi, commenti, line breaks, caratteri ridondanti) senza alterarne la funzionalità. Questo riduce le dimensioni dei file CSS e JavaScript, velocizzando download, parsing ed esecuzione, con impatti diretti su tutti i Core Web Vitals.

Per i file CSS, la minificazione può ridurre le dimensioni del 20-30% in media, mentre tecniche avanzate includono la rimozione di regole non utilizzate (CSS purgation), l’inlining del CSS critico direttamente nell’HTML per eliminare richieste di rete aggiuntive, e la divisione del CSS in bundle specifici per pagina. Tool come PurgeCSS, Critical o plugin per build system (webpack, Vite) automatizzano questo processo durante il deployment.

Il JavaScript richiede particolare attenzione poiché impatta direttamente sull’INP: file JS pesanti bloccano il rendering e rallentano l’interattività. Oltre alla minificazione, strategie efficaci includono il code splitting per caricare solo il codice necessario per la pagina corrente, il lazy loading di librerie non critiche, l’uso di attributi async o defer per evitare il blocking, e la rimozione di dipendenze inutilizzate.

Per applicazioni moderne, l’utilizzo di bundler che supportano tree-shaking (eliminazione automatica di codice non utilizzato) è fondamentale.

L’implementazione può essere gestita attraverso task runner come Gulp o Grunt, bundler moderni come webpack o Rollup, oppure tramite plugin CMS per WordPress, Shopify e altre piattaforme. CDN moderne come Cloudflare offrono anche minificazione automatica a livello di edge, semplificando l’ottimizzazione senza modifiche al codice sorgente.

Mobile-First e Responsive Design

Dal 2019 Google ha adottato definitivamente l’indicizzazione mobile-first, che significa che lo spider utilizza principalmente la versione mobile del sito per valutare contenuti, struttura e fattori di ranking. Questo cambio di paradigma riflette la realtà del traffico web moderno, dove la maggioranza degli utenti accede da smartphone e tablet. Un sito non ottimizzato per mobile non solo offre un’esperienza utente scadente ma rischia penalizzazioni dirette nel ranking, anche per le ricerche desktop.

Il responsive design è l’approccio standard per garantire che un sito si adatti fluidamente a qualsiasi dimensione di schermo, utilizzando media queries CSS, griglie flessibili e immagini responsive. A differenza delle versioni mobile separate (m.esempio.it) o del dynamic serving, il responsive design mantiene un unico URL e HTML per tutti i dispositivi, semplificando la gestione tecnica ed evitando problemi di contenuti duplicati. Google raccomanda esplicitamente questa soluzione come best practice.

Elementi critici per l’ottimizzazione mobile-first includono: viewport meta tag correttamente configurato (<meta name="viewport" content="width=device-width, initial-scale=1">), touch target sufficientemente grandi (minimo 48x48px) e distanziati per evitare click accidentali, font leggibili senza necessità di zoom (minimo 16px per il corpo del testo), e navigazione semplificata con menu hamburger ben implementati.

È fondamentale che il contenuto principale sia identico tra versione mobile e desktop: nascondere contenuti importanti solo su mobile può portare a perdita di ranking poiché Google indicizza prioritariamente quella versione.

Testare regolarmente con il Mobile-Friendly Test di Google e analizzare i report di usabilità mobile in Search Console permette di identificare problematiche come testo troppo piccolo, elementi cliccabili troppo vicini, o contenuti più larghi del viewport. Il test dei Core Web Vitals deve essere effettuato separatamente per mobile e desktop, poiché le performance possono variare significativamente tra dispositivi, con mobile generalmente più critico a causa di connessioni più lente e hardware meno potente.

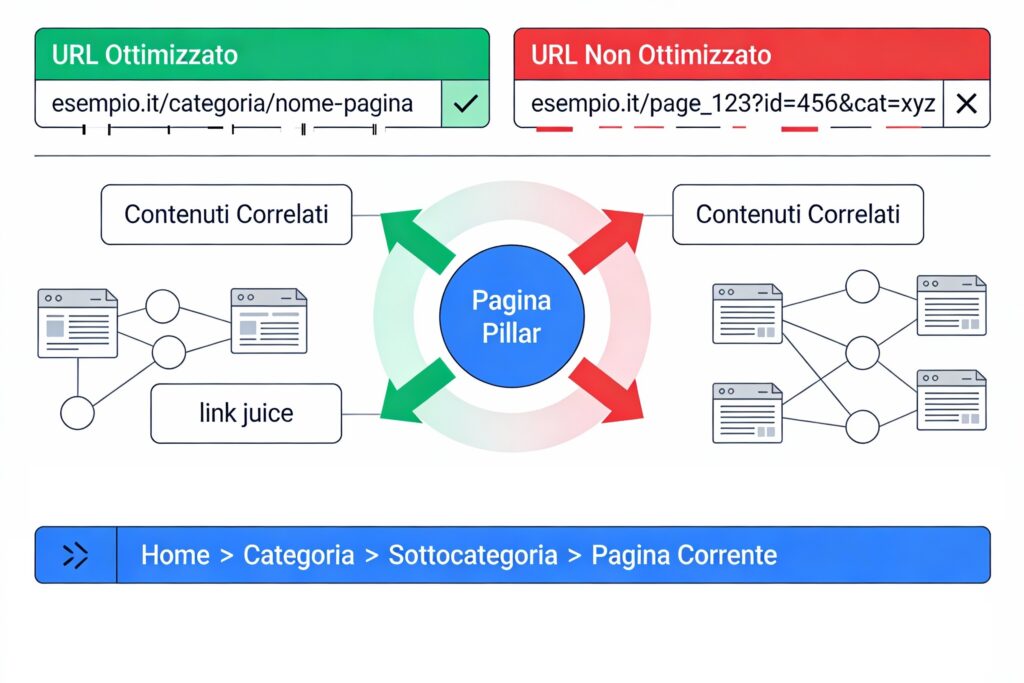

Architettura del Sito e Struttura URL

L’architettura del sito rappresenta l’organizzazione logica e gerarchica dei contenuti, determinando come pagine e sezioni si relazionano tra loro.

Una struttura ben progettata facilita la navigazione degli utenti, migliora la distribuzione del link juice attraverso il sito, e permette ai crawler di comprendere la gerarchia e l’importanza relativa dei contenuti. Un’architettura caotica o troppo profonda può rendere pagine importanti difficili da raggiungere, disperdere autorevolezza e complicare l’indicizzazione.

L’obiettivo è creare una struttura piramidale dove ogni pagina sia raggiungibile dalla homepage in massimo 3-4 click, organizzando i contenuti in categorie logiche e coerenti che rispecchino sia le esigenze degli utenti che la strategia di keyword.

Struttura URL Ottimizzata

Gli URL SEO-friendly sono brevi, descrittivi e leggibili sia per gli utenti che per i motori di ricerca. Un URL ben strutturato comunica chiaramente il contenuto della pagina, contribuisce alla comprensione del contesto e può influenzare positivamente il click-through rate nei risultati di ricerca.

Best practice fondamentali includono: utilizzare parole chiave rilevanti nell’URL senza keyword stuffing, preferire trattini (-) al posto di underscore (_) per separare le parole, mantenere URL brevi e concisi (idealmente sotto i 60-70 caratteri), evitare parametri dinamici quando possibile (es. ?id=123&cat=45), e utilizzare solo lettere minuscole per evitare problemi di duplicazione. La struttura dovrebbe riflettere la gerarchia del sito: esempio.it/categoria/sottocategoria/nome-pagina/ è preferibile a URL come esempio.it/pagina-123/.

Errori comuni da evitare includono URL eccessivamente lunghi con molteplici sottocartelle che creano percorsi profondi, l’uso di caratteri speciali o spazi (sostituiti da %20), date negli URL che invecchiano rapidamente il contenuto, e modifiche frequenti della struttura che generano catene di redirect.

Una volta definita una struttura URL, mantenerla stabile nel tempo è cruciale: ogni modifica richiede redirect 301 appropriati e può causare temporanee fluttuazioni di ranking durante la fase di transizione.

Link Interni e Navigazione

Il link interno è lo strumento principale per distribuire autorevolezza tra le pagine del sito e guidare sia utenti che crawler attraverso i contenuti. Una strategia di internal linking efficace crea percorsi logici di navigazione, rafforza la rilevanza tematica delle pagine collegate, e permette di veicolare PageRank verso pagine strategiche che altrimenti sarebbero difficili da posizionare.

Principi chiave includono: linkare pagine tematicamente correlate per rafforzare i cluster di contenuti, utilizzare anchor text descrittivi che includono keyword rilevanti (evitando “clicca qui” o “leggi di più”), dare priorità a pagine importanti posizionandole più in alto nella gerarchia e linkandole frequentemente da altre sezioni, e mantenere un equilibrio tra link contestuali all’interno del testo e link navigazionali in menu e footer.

La regola generale è che ogni pagina dovrebbe avere almeno 2-3 link interni in entrata e linkare verso 2-5 pagine rilevanti.

Architetture efficaci includono il modello hub-and-spoke dove pagine pillar approfondite linkano a contenuti satellite specifici che a loro volta rimandano alla pillar, e il topic clustering che organizza contenuti attorno a temi centrali collegati tra loro.

Utilizzare strumenti come Screaming Frog permette di identificare pagine orfane (senza link in entrata), link rotti, e analizzare la distribuzione del PageRank interno per ottimizzare la struttura. Menu di navigazione ben progettati, sidebar contestuali e sezioni “articoli correlati” automatizzate aiutano a scalare l’internal linking su siti di grandi dimensioni.

Breadcrumb e Gerarchia

I breadcrumb (briciole di pane) sono elementi di navigazione secondaria che mostrano il percorso gerarchico dalla homepage alla pagina corrente, tipicamente visualizzati nella parte superiore della pagina come: Home > Categoria > Sottocategoria > Pagina corrente.

Oltre a migliorare l’usabilità permettendo agli utenti di risalire facilmente la gerarchia, i breadcrumb hanno un valore SEO significativo.

Dal punto di vista tecnico, i breadcrumb implementati con dati strutturati BreadcrumbList (Schema.org) possono generare breadcrumb visibili direttamente nei risultati di ricerca, sostituendo o integrando l’URL verde e migliorando l’attrattività dello snippet. Questo markup strutturato aiuta Google a comprendere la struttura del sito e la relazione gerarchica tra le pagine, rafforzando la rilevanza tematica delle categorie.

Best practice per l’implementazione includono: mantenere breadcrumb coerenti con la struttura URL, utilizzare sempre il markup Schema.org per massimizzare i benefici SEO, renderli cliccabili tranne l’ultimo elemento (pagina corrente), e posizionarli nella parte superiore della pagina dove sono immediatamente visibili.

Per siti e-commerce con navigazione sfaccettata complessa, i breadcrumb diventano essenziali per permettere agli utenti di capire dove si trovano e ai motori di ricerca di comprendere le relazioni tra prodotti, categorie e filtri applicati.

HTTPS e Sicurezza del Sito

La sicurezza del sito web è diventata un fattore di ranking ufficiale confermato da Google nel 2014, con il protocollo HTTPS (Hypertext Transfer Protocol Secure) che rappresenta lo standard minimo richiesto. HTTPS cripta i dati scambiati tra browser e server attraverso il protocollo SSL/TLS (Secure Sockets Layer/Transport Layer Security), proteggendo informazioni sensibili come password, dati di pagamento e informazioni personali da intercettazioni e attacchi man-in-the-middle.

Il certificato SSL è un certificato digitale che autentica l’identità del sito web e abilita la connessione criptata. Esistono diverse tipologie: certificati Domain Validated (DV) che verificano solo la proprietà del dominio (sufficienti per la maggior parte dei siti), Organization Validated (OV) che richiedono verifica dell’organizzazione, e Extended Validation (EV) che offrono il massimo livello di validazione. I browser moderni mostrano un lucchetto nella barra degli indirizzi per siti HTTPS, mentre segnalano come “non sicuri” quelli ancora su HTTP, creando diffidenza negli utenti.

La migrazione da HTTP a HTTPS richiede pianificazione accurata per evitare perdite di ranking. Passaggi fondamentali includono: acquisire e installare il certificato SSL sul server, implementare redirect 301 da tutte le versioni HTTP alle corrispondenti HTTPS, aggiornare tutti i link interni e riferimenti a risorse (immagini, CSS, JS) per utilizzare HTTPS o percorsi relativi, aggiornare sitemap XML e file robots.txt, e comunicare il cambio tramite Google Search Console.

È anche essenziale verificare che non ci siano contenuti mixed content (risorse HTTP caricate su pagine HTTPS) che generano warning e compromettono la sicurezza. Dopo la migrazione, monitorare attentamente Search Console per individuare errori di scansione o problemi di indicizzazione, e verificare che il traffico organico venga trasferito correttamente alle nuove URL HTTPS.

Dati Strutturati e Schema Markup

I dati strutturati sono codice standardizzato aggiunto all’HTML che aiuta i motori di ricerca a comprendere meglio il contenuto e il contesto delle pagine web. Utilizzando il vocabolario Schema.org, i dati strutturati forniscono informazioni esplicite su entità, relazioni e attributi, permettendo a Google di creare rich snippet e risultati arricchiti nelle SERP che aumentano visibilità e click-through rate.

L’implementazione può avvenire attraverso tre formati principali: JSON-LD (JavaScript Object Notation for Linked Data, raccomandato da Google), Microdata incorporato direttamente negli elementi HTML, e RDFa. JSON-LD è preferibile perché separa il markup dai contenuti visibili, semplificando manutenzione e testing.

Un esempio di markup per un articolo include proprietà come headline, author, datePublished, image e publisher, fornendo a Google tutte le informazioni necessarie per visualizzare rich snippet con immagine, data e autore.

Tipi di Markup più Comuni

I principali schema markup con impatto SEO significativo includono:

- Article/BlogPosting: per contenuti editoriali, abilita rich snippet con immagine anteprima, data pubblicazione e autore nelle news e nella ricerca generale

- Product: per e-commerce, mostra valutazioni, prezzi, disponibilità e recensioni direttamente nei risultati di ricerca, aumentando drasticamente il CTR

- Review/AggregateRating: visualizza stelle di valutazione aggregate, particolarmente efficaci per prodotti, servizi locali e recensioni

- Recipe: per contenuti food, genera rich snippet con immagine, tempo preparazione, calorie e valutazioni, con possibilità di apparire in posizione zero

- Event: mostra data, luogo, disponibilità biglietti per eventi, concerti, webinar

- LocalBusiness: fondamentale per SEO locale, include indirizzo, orari apertura, contatti, valutazioni

- FAQ: crea accordion espandibili direttamente nelle SERP, occupando più spazio e aumentando visibilità

- HowTo: per guide step-by-step, mostra passaggi numerati con immagini direttamente nei risultati

- Breadcrumb: visualizza percorso gerarchico al posto dell’URL nei risultati di ricerca

- Organization: definisce informazioni aziendali, logo, contatti, profili social per il Knowledge Panel

Implementare dati strutturati richiede attenzione ai dettagli: proprietà obbligatorie devono essere sempre presenti, le informazioni devono corrispondere esattamente al contenuto visibile sulla pagina, e ogni tipo di schema ha linee guida specifiche da rispettare per evitare penalizzazioni. Lo Strumento di Test dei Dati Strutturati di Google e il Rich Results Test permettono di validare il markup prima della pubblicazione.

Monitorare il report “Miglioramenti” in Search Console aiuta a identificare errori o avvisi che potrebbero impedire la generazione di rich snippet, massimizzando così il potenziale di visibilità nei risultati di ricerca.

Gestione degli Errori e Redirect

La gestione degli errori e dei redirect è un aspetto cruciale della SEO tecnica che impatta direttamente sulla user experience e sulla capacità dei motori di ricerca di scansionare efficacemente il sito.

Errori non gestiti causano frustrazione negli utenti, spreco di crawl budget e dispersione di link equity. Una strategia proattiva di monitoraggio e risoluzione delle problematiche tecniche previene perdite di traffico organico e mantiene l’integrità strutturale del sito nel tempo, specialmente durante migrazioni, ristrutturazioni o aggiornamenti di piattaforma.

Errori 404 e Pagine Non Trovate

L’errore 404 si verifica quando un utente o un crawler tenta di accedere a una pagina che non esiste più o il cui URL è stato digitato erroneamente. Mentre occasionali errori 404 sono normali e inevitabili (rappresentano parte del ciclo di vita naturale di un sito), un numero elevato di 404 su pagine precedentemente indicizzate o linkate indica problemi strutturali che richiedono intervento immediato.

Per individuare gli errori 404, Google Search Console offre il report “Copertura” che elenca tutte le pagine che restituiscono questo codice di stato, indicando anche le fonti dei link che puntano a URL non funzionanti. Strumenti come Screaming Frog, Sitebulb o SEMrush Site Audit permettono scansioni complete del sito per identificare link interni rotti, mentre il monitoraggio dei log del server rivela 404 generati da bot esterni o backlink obsoleti. Analizzare il traffico storico tramite Google Analytics aiuta a prioritizzare gli interventi sulle pagine che ricevevano traffico significativo.

Le strategie di risoluzione variano in base al contesto: per pagine eliminate definitivamente senza equivalente, lasciare il 404 è appropriato ma è consigliabile personalizzare la pagina di errore con navigazione utile, ricerca interna e link ai contenuti popolari. Per pagine spostate o rinominate, implementare redirect 301 permanenti verso la nuova locazione o verso contenuti equivalenti pertinenti.

Evitare assolutamente i “soft 404” (pagine che mostrano contenuto di errore ma restituiscono codice 200 OK) che confondono i motori di ricerca, e non reindirizzare massivamente tutti i 404 alla homepage, pratica che disperde link equity e crea una cattiva user experience. Per contenuti stagionali o temporaneamente rimossi, considerare redirect 302 temporanei o il codice 410 (Gone) che comunica a Google la rimozione definitiva accelerando la deindicizzazione.

Redirect 301 vs 302

I redirect sono risposte del server che indirizzano automaticamente browser e crawler da un URL a un altro, essenziali durante migrazioni, ristrutturazioni e consolidamenti di contenuti. Comprendere la differenza tra redirect permanenti e temporanei è fondamentale per preservare il valore SEO.

- Il redirect 301 (Moved Permanently) indica che la risorsa è stata spostata definitivamente alla nuova locazione. Questo trasferisce la quasi totalità del link juice (PageRank) all’URL di destinazione, consolida i segnali di ranking e comunica a Google di sostituire nell’indice il vecchio URL con il nuovo.

- I redirect 301 sono la soluzione standard per: migrazioni di dominio, ristrutturazioni URL, consolidamento di contenuti duplicati, passaggio da HTTP a HTTPS, e eliminazione permanente di pagine con reindirizzamento a contenuti equivalenti.

Google impiega solitamente qualche settimana per trasferire completamente i segnali, durante le quali possono verificarsi temporanee fluttuazioni di ranking.

- Il redirect 302 (Found/Temporary Redirect) indica uno spostamento temporaneo, suggerendo che la risorsa tornerà alla locazione originale. Tradizionalmente i 302 non trasferivano PageRank, ma Google ha dichiarato che nei contesti moderni gestisce 301 e 302 in modo simile per quanto riguarda il trasferimento di link equity.

- Il 302 comunica di mantenere nell’indice l’URL originale piuttosto che sostituirlo, rendendolo appropriato per: manutenzione temporanea del sito, contenuti stagionali che torneranno alla locazione originale, test A/B di nuove versioni, e redirect geografici o device-specific temporanei.

La scelta errata tra 301 e 302 può causare problemi: utilizzare 302 per cambiamenti permanenti ralenta o impedisce il trasferimento di ranking al nuovo URL, mantenendo indicizzato l’URL obsoleto. Viceversa, un 301 per situazioni temporanee forza la deindicizzazione dell’URL originale, complicando il ritorno alla configurazione precedente. Verificare sempre l’implementazione tramite strumenti come Redirect Checker o analizzando gli header HTTP per assicurarsi che il codice di stato sia quello desiderato.

Catene di Redirect

Le catene di redirect si verificano quando un URL reindirizza a un secondo URL che a sua volta reindirizza a un terzo, e così via: URL-A → URL-B → URL-C → URL-finale.

Questa situazione emerge tipicamente dopo migrazioni multiple, ristrutturazioni successive o manutenzione non coordinata nel tempo, creando percorsi inefficienti che penalizzano sia performance che SEO.

I problemi generati dalle catene includono: rallentamento significativo del caricamento poiché ogni redirect richiede un round-trip HTTP aggiuntivo, consumo inutile di crawl budget con i bot che devono seguire multipli hop prima di raggiungere il contenuto finale, potenziale perdita di link equity (anche se Google afferma di gestirlo, catene troppo lunghe possono causare dispersione), e rischio che crawler o browser abbandonino dopo troppi redirect, specialmente se si superano i 5 hop. Alcuni bot seguono solo un numero limitato di redirect prima di abbandonare, lasciando pagine non scansionate.

Le soluzioni richiedono un approccio sistematico: audit regolari con Screaming Frog o tool simili per identificare tutte le catene presenti, aggiornamento dei redirect per puntare direttamente all’URL finale bypassando gli hop intermedi, priorità agli interventi su catene che coinvolgono pagine ad alto traffico o con molti backlink, e aggiornamento dei link interni per puntare direttamente alle destinazioni finali evitando redirect completamente. Durante migrazioni pianificate, mappare gli URL vecchi direttamente ai nuovi evitando di creare catene sovrapponendo redirect a redirect esistenti.

Un principio fondamentale è: ogni URL dovrebbe reindirizzare con massimo un hop alla destinazione finale, preferibilmente zero hop per i link interni. Monitorare Search Console per avvisi su redirect eccessivi e verificare che le pagine più importanti siano raggiungibili senza intermediari mantiene l’efficienza del sito e preserva il valore SEO accumulato.

JavaScript e Rendering

L’uso massiccio di JavaScript nei siti web moderni, specialmente con framework come React, Vue, Angular e applicazioni single-page (SPA), introduce sfide significative per la SEO. A differenza dell’HTML statico immediatamente leggibile, il contenuto generato dinamicamente da JavaScript richiede che i motori di ricerca eseguano il codice per vedere ciò che gli utenti vedono, un processo chiamato rendering che è più complesso, lento e soggetto a limitazioni rispetto alla semplice lettura dell’HTML.

Google utilizza un processo a due fasi: prima scansiona l’HTML iniziale (che nei siti JavaScript-heavy può essere quasi vuoto), poi mette le pagine in una coda di rendering dove Googlebot esegue JavaScript per generare il DOM finale.

Questo rendering differito può causare ritardi di giorni o settimane nell’indicizzazione di nuovi contenuti, e se il JavaScript fallisce o richiede troppo tempo, Google potrebbe indicizzare solo l’HTML base senza i contenuti dinamici. Problematiche comuni includono: contenuti critici (titoli, testi, link interni) generati solo lato client e invisibili senza JavaScript, lazy loading implementato in modo che Google non veda immagini o sezioni importanti, navigazione SPA che non aggiorna l’URL rendendo difficile l’indicizzazione di singole “pagine”, e risorse bloccate dal robots.txt che impediscono l’esecuzione corretta di script necessari al rendering.

Soluzioni e best practice per garantire indicizzazione corretta includono: implementare Server-Side Rendering (SSR) che genera HTML completo sul server prima di inviarlo al browser, eliminando la dipendenza dal rendering JavaScript per i contenuti critici. Framework moderni come Next.js (React) e Nuxt (Vue) facilitano l’implementazione di SSR. Alternativamente, Static Site Generation (SSG) pre-renderizza pagine in HTML statico al momento del build, ideale per contenuti che cambiano raramente.

Il pre-rendering dinamico serve HTML pre-renderizzato ai bot e JavaScript agli utenti reali, pur richiedendo attenzione per non violare le linee guida contro il cloaking.

Testare regolarmente con Mobile-Friendly Test e URL Inspection Tool in Search Console mostra esattamente come Google renderizza le pagine, evidenziando contenuti mancanti o errori JavaScript. Implementare una progressiva enhancement strategy assicura che i contenuti base siano accessibili nell’HTML iniziale anche se JavaScript fallisce. Per la navigazione SPA, utilizzare l’History API per aggiornare correttamente gli URL e implementare tag canonical, meta tag e structured data in modo dinamico per ogni “pagina” virtuale.

Evitare infinite scroll senza paginazione URL-based, preferendo caricamento sequenziale con URL univoci per ogni “pagina” di contenuti. Infine, verificare che robots.txt non blocchi file JavaScript, CSS o API necessari al rendering corretto, e monitorare Core Web Vitals considerando che JavaScript pesante impatta negativamente su INP e altri parametri di performance.

Strumenti per la SEO Tecnica

L’ottimizzazione tecnica richiede strumenti specializzati per audit, monitoraggio e testing. I principali tool utilizzati dai professionisti SEO includono:

- Google Search Console: piattaforma gratuita essenziale che fornisce dati diretti da Google su indicizzazione, copertura, performance, Core Web Vitals, usabilità mobile, dati strutturati ed errori di scansione

- PageSpeed Insights: analizza velocità e performance di pagine specifiche fornendo punteggi Core Web Vitals sia per mobile che desktop, con raccomandazioni dettagliate per l’ottimizzazione

- Screaming Frog SEO Spider: crawler desktop che scansiona siti fino a 500 URL gratuitamente (illimitato a pagamento), identificando errori tecnici, redirect, contenuti duplicati, problemi di link e audit completi dell’architettura

- Google Lighthouse: strumento open source integrato in Chrome DevTools che audit performance, accessibilità, SEO, PWA e best practice con punteggi dettagliati e suggerimenti di miglioramento

- Ahrefs Site Audit: crawler cloud-based che identifica oltre 100 problemi tecnici SEO, monitora la salute del sito nel tempo e fornisce priorità agli interventi basate sull’impatto

- SEMrush Site Audit: tool completo per audit tecnici con crawl programmabili, tracking dei problemi risolti, analisi tematiche e integrazioni con Google Analytics e Search Console

- GTmetrix: analizza performance di caricamento con metriche dettagliate, waterfall delle risorse, video del caricamento e confronti temporali per monitorare miglioramenti

- Sitebulb: crawler desktop visuale che presenta dati complessi attraverso grafici intuitivi, ideale per visualizzare architettura del sito, flusso del link juice e prioritizzazione degli interventi

- Bing Webmaster Tools: equivalente Microsoft di Search Console, utile per ottimizzare su Bing e identificare problemi che potrebbero affliggere anche l’indicizzazione Google

- Schema Markup Validator: tool ufficiale di Schema.org per validare l’implementazione dei dati strutturati e verificare conformità agli standard

- Mobile-Friendly Test: verifica rapidamente se una pagina è ottimizzata per mobile e mostra come Googlebot visualizza la versione mobile

- Chrome DevTools: suite integrata nel browser con Network tab per analizzare richieste, Performance tab per profiling dettagliato, e Console per debug JavaScript

- Log File Analyzer (es. Screaming Frog Log Analyzer, Botify): analizza log del server per comprendere il comportamento reale dei crawler, identificare pagine ignorate e ottimizzare crawl budget

- Redirect Checker: strumenti come Redirect Path (estensione Chrome) o checker online che mostrano catene complete di redirect con codici di stato HTTP

L’utilizzo combinato di questi strumenti fornisce una visione completa dello stato tecnico del sito, permettendo di identificare priorità, monitorare progressi e mantenere standard elevati di ottimizzazione nel tempo.

Fonti utili e rilevanti